Robots.txt जिसको Robots Protocol के नाम से भी जाना जाता है Robots TXT files वेबसाइट crawl और वेबसाइट पर उपस्थित अन्य वेब पृष्ठ के साथ संचार के लिए एक मानक मात्र है.

मुख्य रूप से इस फाइल को वेबसाइट में इस लिए इस्तेमाल किया जाता है जो की सर्च कंसोल को बता सकें की वेबसाइट के किन हिस्सों को सर्च इंजिन में इंडेक्स करना है और किन हिस्सों को सर्च इंजन में इंडेक्स नही करना है.

Robots.txt file बहुत ही कम एमबी की एक बहुत ही छोटी सी फाइल होती है जो की root folder के अंदर में होती हैै वेबसाइट को क्राॅल और इंडेक्स करने में इस फाइल का अहम योगदान रहता है इसलिए हर एक ब्लॉगर को robots.txt file जरूर बनाना चाहिए.

इसलिए आज हम इस पोस्ट में जानेंगे कि Robots.txt फाइल क्या है और Robots.txt Kaise Banaye तो आइए जानते हैंं.

Robots.txt File क्या हैं

Robots.txt file Website को crawl और वेबसाइट के किसी एक हिस्सें को इंडेक्स करने के लिए बनाई जाती है जिसमे कुछ इस प्रकार से text को डिजाइन किया जाता है जिससे सर्च कंसोल वेबसाइट के किसी एक हिस्सों को crawl और index करता है.

और robots website के उन हिस्सों को सर्च करता है जिसको इस जो txt file में मजूद होते है जिसको allow और disallow से sindicate किया जाता है.

Robots.txt वेबसाइट के लिए क्यों आवश्यक हैं

जब एक bots search engine word wide web को व्यवस्थित रूप से ब्राउज करता है तो यह स्पाइडर Robots txt file को फॉलो करता है जिसके द्वारा जी वेबसाइट के कुछ हिस्सों को क्राउल और इंडेक्स करता है.

यही इसके विपरित यदि वेबसाइट / ब्लॉग पर Robots txt file, bots (spiders) को नही मिलती है यह वेबसाइट के सभी हिस्सों को Crawl और index करने लगता है जिसके परिणाम स्वरूप ब्लॉग / वेबसाइट पर उपस्थित सारे मैटेरियल को bots search engine मे index कर देता है.

यदि वही वेबसाइट पर robots txt file, bots को नही मिलती है तो वह वेबसाइट के सारे stracture को सर्च इंजिन में इंडेक्स करने लगता है लेकिन वेबसाइट ब्लॉग पर robots txt file, bots को मिलती है तो bots robots txt file के अनुसार ही कंटेंट को सर्च इंजन में इंडेक्स करता है.

क्योंकि जब भी किसी भी वेबसाइट या ब्लॉग के कंटेंट को सर्च इंजन में bots index करता है तो वह वेबसाइट पर बनी robots txt file के stractur को फॉलो करता है फिर उसके बाद ही वेबसाइट के कंटेंट को सर्च इंजिन भी इंडेक्स करता है.

robots.txt file website पर न होने के कारण bots website के हर एक हिस्से को search engine में इंडेक्स कर देता है जिसके डुप्लीकेट कंटेंट की संभावना वेबसाइट पर अधिक बढ़ जाती है डुप्लीकेट कंटेंट से पीछा छुड़नेंके लिए txt file बनाना अतिआवश्यक है.

Robots.txt file के क्या फायदे हैं

जैसा कि आपने ऊपर जाना है की robots txt file ब्लॉग वेबसाइट के लिए कितना मायने रखता है अब txt file के फायदे क्या है इसके बारे में जानकारी प्राप्त करते है.

- website के उन हिस्सों को Crawl और index करता है जिनको Robots txt file me दर्शाया जाता हैं.

- आप अपने मन के मुताबिक वेबसाइट के कंटेंट को सर्च इंजिन में इंडेक्स कर सकते है.

- आप वेबसाइट के किसी भी पृष्ठ को robots.txt के द्वारा ब्लॉक कर सकते है.

- वेबसाइट के किसी भी part को प्राइवेट कर सकते है.

- वेब पेज crawl index को delay कर सकते है.

- duplicate page को SERPs दिखने की अनुमती नही देता है.

Website में Robots.txt फाइल कहाँ रहता है

वर्डप्रेस पर बनी वेबसाइट में Robots.txt file वेबसाइट के Root folder में रहता है जिसके जरिए bots वेबसाइट को Crawl और index करता है यदि bots को वेबसाइट के Root folder में रोबोट्स टीएक्सटी फाइल नही मिलती है तो वह पूरी वेबसाइट को Crawl और index करने लगता है.

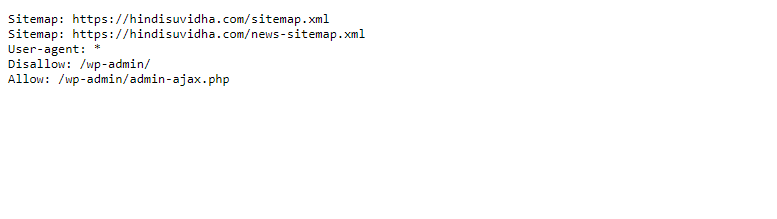

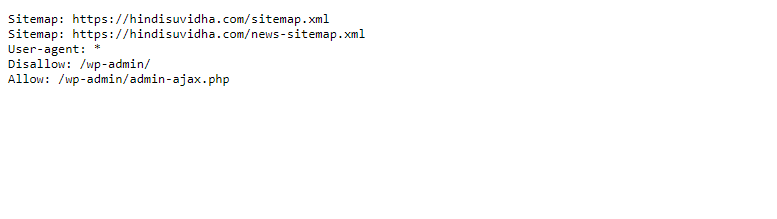

अगर आप WordPress User हैं किंतु आपको नही पता है की वेबसाइट पर Robits.txt file हैं की नही, Robots txt file का पता लगाने के लिए सर्च इंजिन के एड्रेस बार में आपको कुछ इस प्रकार से टाइप करना है https://your website url.com/robots.txt

और सर्च करना है आपकी वेबसाइट की Robots txt file आपके सामने होगी, आप नीचे स्क्रीन शॉट में देख सकते है कुछ इस तरह से रोबोट्स टीएक्सटी फाइल होती है.

ठीक ऐसी ही robots txt file होती है आप Google search console Tester tools के जरिए भी इस फाइल को देख सकते है.

Robots.txt File के Format

Robots. txt file के जरिए आप वेबसाइट के किसी भी हिस्से को सर्च इंजिन में इंडेक्स कर सकते है और नही भी कर सकते है जिसके लिए robots txt file का उपयोग किया जाता है जिसके परिणाम स्वरूप बोट प्रदशन करता है.

txt file command के जरिए run करती है जिनमे कई कमांड का इस्तेमाल किया जाता है जिनमे से 2 मुख्य कमांड Allow & Disallow है इनके अलावा और भी कमांड है जिनका robots.txt में इस्तेमाल किया जाता है नीचे कुछ Robots txt Command के नाम और वह कैसे run करते है बताया गया है.

User-agent: अगर आप bots search engine को same command run करने का Signal देना चाहते है तो user-agent के * का इस्तेमाल किया जाता है कुछ इस प्रकार से user-agent:*

Allow: नाम से स्पष्ट है इसके द्वारा किसी वेबसाइट के किसी particular हिस्से को index और crawler करने के लिए उपयोग किया जाता है.

Disallow: इस कमांड के द्वारा स्पाइडर को आदेश दिया जाता है की वेबसाईट के किन हिस्सों को सर्च इंजन में इंडेक्स नही करना है केवल उन्हीं हिस्सों को यह टारगेट करता है.

Crawl delay: इस कमांड के द्वारा वेबसाइट को कितने सेकेंड या कितने मिनट के अंदर crawl और index करना है उसके लिए इस कमांड का इस्तेमाल किया जाता हैं.

Sitemap: इसका उपयोग XML Sitemap के स्थान को Crawl करने के लिए इस्तेमाल किया जाता है जो Google, Bings, Yahoo पर प्रदाशित क्या जाता है.

सभी Web Crawlers को वेबसाइट Index करने से रोकना का कमांड

User-agent:*

Disallow: /

उपरोक्त कमांड के जरिए वेब क्राउलर बोट्स को वेबसाइट को crawl करने से रोका जा सकता है.

एक Specific Folder को Specific Web Crawlers के लिए Block करने का कमांड

User-agent: Googlebot

Disallow: /example-subfolder/

इस कमांड के द्वारा Bots वेबसाइट को Crawl करने से रोकता है वाही यदि आप वेबसाइट के सभी Crawler को Block करना चाहते है तो उसकी txt file कुछ इस प्रकार से होगी.

User-agent: */

Disallow: /example-subfolder/

इसके विपरीत यदि आप Specific Crawlers को Block करना चाहते है तो उसका कमांड इस प्रकार से होगा,

User-agent: Bingbot

Disallow: /page URL

Robots.txt file Kaise Banaye – Make Robots txt file in hindi

यदि आप अपने ब्लॉग के Domain Name के आगे example.com/robots.txt गूगल सर्च बॉक्स में टाइप करके सर्च करते है और वहां पर आपको आपके ब्लॉग की Robots txt file मिल जाती है.

और आपको लगता है की इस Robot.txt file में कुछ Changes करना चाहिए और आपको लगता है की बदलाव करकने के बाद Bots आपके ब्लॉग वेबसाइट को सुचारू रूप से क्रॉल और इंडेक्स करगा.

तो आप Robots .txt file को edit भी कर सकते है txt file को Edit करने के लिए Yoast SEO Plugin की जरुरत पड़ेगी, यदि आके पास पहले से ही है तो बहुत ही अच्छी बात है नहीं तो आप इस Yoast SEO Plugin को Install कर सकते है.

प्लगइन को इनस्टॉल करने के बाद आपको Yoast>>Tools पर क्लिक करना है Yoast SEO Tools के आप्शन में 3 Hyper link दिए हुए होते है पहला import and export दूसरा File editor तीसरा Bulk editor

जिनमे से आपको File editor वाले लिंक पर क्लीक करना है जैसे ही आप फाइल एडिट पर क्लिक करते है Edit font में robot.txt file आपके सामने होती है.

जिसमे आप अपने मन के मुताबित किसी भी तरह का बदलाव् कर सकते है जो भी Command आप Robot txt file में रन करना चाहते है उस कमांड को टाइप करके नीचे Save Change to Robot.txt file की बटन पर क्लिक करके txt file को save करलें, इस तरह से आप Robots txt file edit कर सकते हैं.

इसे भी पढ़े

- Best Blogging Tips in Hindi

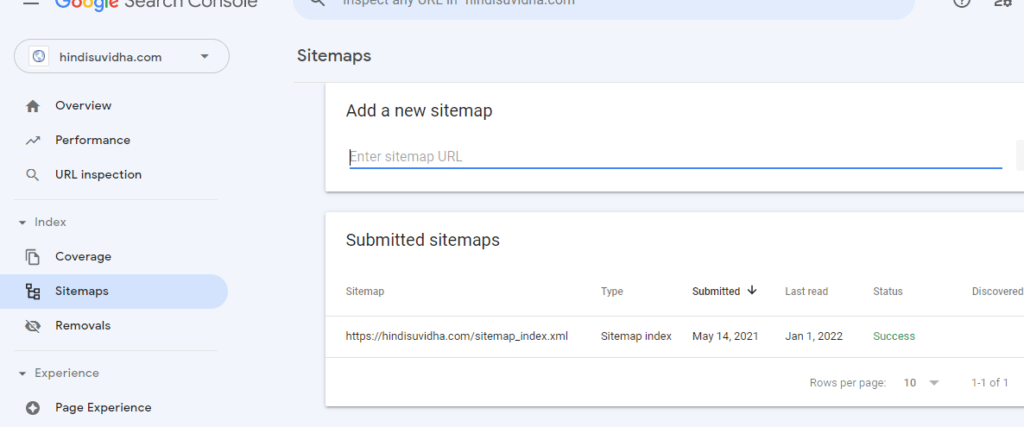

- WordPress Website के लिए Google Search Console में Sitemap कैसे सबमिट करें

- image seo कैसे करे

- Backlink क्या है

- Website की Loading Speed कैसे बढ़ाये

छोटा सा निवेदन, अगर यह आर्टिकल आपके लिए मददगार साबित हुआ है, तो इसे शेयर करना न भूलें

आज आपने क्या सीखा

तो दोस्तों आपको यह लेख Robot txt file क्या है और Robots.txt file edit कैसे करें, आपको कैसा लगा, मैं उम्मीद करता हूँ की आप लोगो को यह लेख जरुर पसंद आया होगा.

मैंने अपनी तरफ से Perfect robot txt file कैसे बनाये पूरी जानकारी हिंदी में दि है फिर भी आपको लगता है की इस Post में कोई गलती रह गयी है.

या फिर आर्टिकल पूरा नही है, तो आप नीचे Comment Box में Comments करके हमें सूचित कर सकते है और हम इस आर्टिकल को सुधारने की पूरी कोशिश करेंगे, यहाँ तक पोस्ट पढ़ने के लिए आपका दिल से आभार.

मैं हिन्दराज हिंदीसुविधा ब्लॉग का Founder हूँ. मुझको टेक्नोलॉजी से जुड़े रहना और उनके बारे में शोध करना बेहद पसंद है. और इसको आगे बढ़ाते हुए मैं इस ब्लॉग पर टेक्नोलॉजी और नए अपडेट से जुड़े लेख प्रकाशित करता हूँ निचे दिए गए लिंक के द्वारा आप इनको Follow कर सकते है,